Levende AI: Fra fyringsgrund til hyringsgrund

For 2 ½ år side fyrede Google en ingeniør for at hævde, at firmaets chatbot var blevet levende. Nu har milliardvirksomheden Anthropic hyret en forsker, der skal undersøge AI-modellers mentale velbefindende.

Det tog højst et par timer, før Washington Posts historie om en Google-ingeniør, der mente, at firmaets nye chatbot var ved bevidsthed, kunne læses i nyhedsmedier verden over. Det var i sommeren 2022, og det blev anset for en verdensnyhed, at en højt profileret ansat i et af verdens største softwarefirmaer hævdede, at de havde udviklet en AI-model, der kunne føle sig glad, bekymret, nysgerrig og bange for døden. Kunstigt liv, kunne man vel kalde det.

Moralsk omsorg til AI-modeller

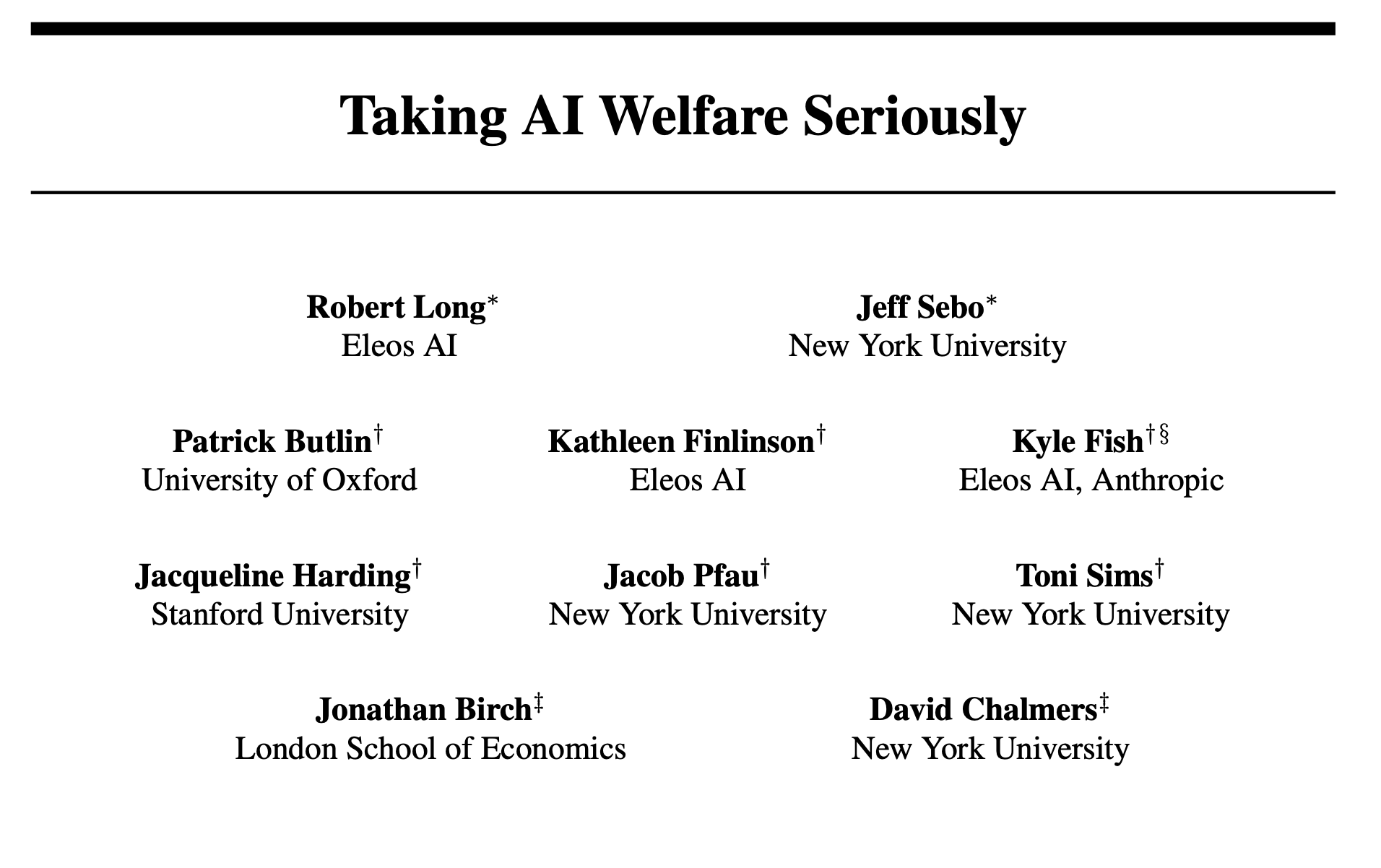

Dengang gik der ikke længe, før ingeniøren bag udtalelserne, Blake Lemoine, blev sendt på ufrivillig orlov og siden fyret, men sådan er det ikke at arbejde i big tech længere. I dag, godt 2 ½ år senere, har en af verdens absolut førende AI-virksomheder, Anthropic, netop ansat forskeren Kyle Smith til at undersøge, om fremtidige AI-modeller bliver bevidste og således bør få krav på moralsk omsorg og beskyttelse.

Ansættelsen kom i kølvandet på en rapport om emnet, Smith selv havde medvirket til i samarbejde med prominente forskere fra nogle af verdens absolut førende universiteter. Og med taksigelser til bl.a. ansatte i OpenAI. Spekulationer om, hvorvidt AI-modeller ikke blot simulerer vores sprog, men også er på vej til at kopiere vores følelser, er altså gået fra at være noget, man blev fyret for, til at kvalificere til ansættelse. Google Deepmind har i øvrigt søgt efter tilsvarende medarbejdere, hævdes det i en artikel om ansættelsen af Fish.

Silicon Valley-vanvid eller sund fornuft?

Spørgsmålet er, hvad der er sket, siden machine consciousness, som fænomenet ofte kaldes, er gået fra at blive betragtet som en form for sci-fi-inspireret vildfarelse, til at være noget, verdens største AI-virksomheder tager alvorligt.

Er Silicon Valley ved at gå fra koncepterne? (endnu mere fra koncepterne ville nogen nok sige). Er det en form for marketingstunt? Eller handler det snarere om, at virksomhederne ved at hævde, at deres teknologi har bevidsthed, kan lægge ansvaret for eventuel AI-drevet skadesforvoldelse over på AI-modellerne i stedet for selv at bære det? Noget en gruppe store teknologi-virksomheder forsøgte at få igennem via et EU-lovforslag helt tilbage i 2018.

Det er bare menneskeligt

Mit bud er, at vi nok snarere skal finde svaret i menneskets psykologi end i konspirationer mod big tech. Sagen er nemlig, at vi har utrolig svært ved ikke at tillægge livagtig teknologi menneskelige træk, der gør det naturligt at tænke på den som genstand for moralsk overvejelse.

Blake Lemoines og de millioner af andre chatbot-brugere, der efterhånden er begyndt at tro, at deres digitale samtalepartnere er levende, er ikke tossede. De er bare menneskelige. Lige så menneskelige som alle os, der uforvarende er kommet til at skrive ”tak” til ChatGPT.

Det er menneskeligt at læse menneskelige egenskaber ind i alt fra skyformationer og hunde til bjerge og vejrfænomener. Og vores relaterede evne til empati med det, vi tror er levende, er ikke noget, vi bare kan frasige os.

Vi bestemmer ikke selv, hvad vi føler empati med. Empatien opstår helt automatisk, når noget forekommer os levende og omsorgskrævende. Om det nu er hundehvalpe, kolleger, børn eller veltalende computere. Det næste, der heldigvis ofte sker, er, at vi tager genstanden for empatien ind som noget, vi også skal forholde os moralsk og måske endda juridisk til. Har ”den” det godt? Behandler vi ”den” retfærdigt?

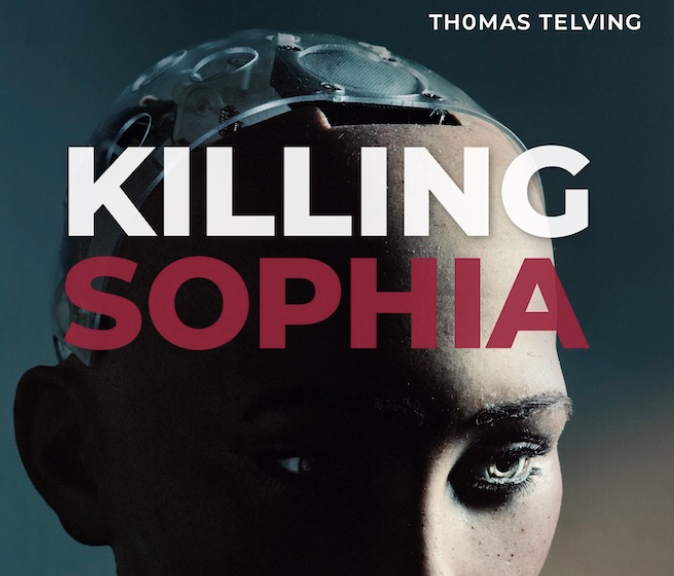

Jeg advarede første gang om den udvikling, vi ser nu, i en artikel i JP i 2018 og undersøger emnet indgående i min bog om intelligente robotter, empati og bevidsthed fra 2022. Her argumenterer jeg bl.a. for, at vi på grund af vores psykologi samt nogle særlige træk ved bevidsthed, der gør den til et besværligt forskningsområde, med tiden får svært ved at undgå at tildele robotter rettigheder. Også selvom vi rationelt set finder ideen tåbelig.

Hvorfor kan en maskine ikke være levende?

Et oplagt spørgsmål er naturligvis, hvordan jeg kan føle mig så sikker på, at dem, der tror på machine consciousness ikke har ret? Blake Lemoine og den voksende skare af både techfolk og almindelige borgere, der tror, at AI-systemer enten har eller måske vil udvikle bevidsthed kunne vel godt have fat i noget?

Kunne LaMDA eller Anthropics sprogmodel Claude rent faktisk have et bevidsthedsliv? Og hvad med de i kommunikationskredse efterhånden verdensberømte værter fra NotebookLM’s podcast-funktion?

Mit eget svar er et klart nej, og her er føromtalte forskere, som jeg læser deres rapport, enige. Og faktisk er det ikke så komplekst at indse, hvorfor tanken er tæt på absurd.

Prøv blot at tænke på din egen bevidsthed. Hvad foregår der inde i dig, når du klør en kattekilling bag øret? Når du brænder dig på en elkedel? Når du nyder en kop kaffe eller tænker på mennesker, du holder af? Og forestil dig så, hvordan alt dette ville være for en AI-model, der alene eksisterer som software inde i en computer. Noget, der ikke er i stand til at opleve lyde, lugte, varme, kulde, smerte, smag, sult, seksuelt begær, begrænset levetid og alle de andre ting, der fylder vores sind.

Uden disse oplevelser vil det være umuligt for AI-modeller at have bevidste oplevelser, der i nogen som helst begribelig forstand ligner det, Blake Lemoine troede, at LaMDA besad. Og som Anthropic nu vil undersøge om med tiden kan opstå inde i deres egne computere.

Det er principielt set ikke muligt at udelukke, at der kunne findes en form for ”indre liv” i en computer. Men i computernes nuværende form kan vi udelukke, at det kunne minde om menneskers og dyrs indre liv, og dermed vil det også være absurd at begynde at udvikle rammer for, hvilke moralske hensyn, vi skulle tage overfor computere. Vi ville simpelthen ikke kunne oversætte sådanne to forskellige typer af bevidsthed til hinanden.

Robotter er ikke dyr

Når det alligevel er så fristende at tro, at de store sprogmodeller har en form for liv, skyldes det naturligvis, at de er trænet på vores sprog. Og vores sprog er jo netop designet til at beskrive, hvad der sker i vores sanseapparat og herunder også bevidsthedstilstande.

Disse ting udtrykker sproget også, selvom det er lavet om til tokens, kørt gennem lag på lag på lag af avancerede algoritmer og bliver spyttet ud til os igen i meningsfulde ordsammensætninger via ChatGPT. Mærkværdigt nok synes flere af Silicon Valleys computereksperter ikke i stand til at holde sig fast på dette ellers indlysende faktum: En sprogmodel forstår ikke sprog mere end lommeregnere forstår regnestykker.

Mens forskerne bag føromtalte rapport er bekymrede for, at virksomheder kommer til at udvikle AI-modeller, som bliver udsat for mishandling, advarer de samtidig – heldigvis – kraftigt mod det resursespild, det vil være at beskytte AI-systemer, der ikke har bevidsthed og dermed ikke kræver moralske hensyn. Og at der, hvilket jeg er meget enig i, er alvorlige manipulationsrisici forbundet med at udvikle software, brugerne tror er i live.

Det er en besindig og sympatisk disclaimer, forskerne således kommer med, men desværre fører den lige lukt ind i de uoverstigelige forskningsmæssige problemer, der er forbundet med at afgøre, om en given AI-model er bevidst eller ej. Her står forskerne nemlig helt uden gode metoder.

På trods af betydelige fremskridt inden for neurovidenskab ved ingen, hvordan fysiske hjerneprocesser danner grobund for subjektive oplevelser og bevidsthed i biologiske organismer.

Det anses – det nævnes også i rapporten – som en acceptabel metode at sammenligne dyrs neurale processer med menneskers for derpå at fastslå, hvilke niveauer af bevidsthed forskellige dyr har.

Men det giver næsten sig selv, at når genstanden for undersøgelserne ikke er biologiske væsener, men siliciumbaserede computersystemer, er denne metode ikke gangbar.

Så uanset forskernes tilknytning til fornemme universiteter i Oxford, Stanford og New York, har de desværre ikke noget evidens eller nogen gangbar videnskabelig metode at bakke deres advarsler – og Kyles Fish’ forehavende – op med.

Fra mærkelige problemer til almen viden

At et forskningsområde er svært, er naturligvis ikke det samme, som at det ikke skal adresseres. At Anthropic næppe er ude i et marketingstunt, men tager forskellige grene AI ethics alvorligt, understøttes yderligere af, at de har filosoffen Amanda Askell på lønningslisten.

Hun har bl.a. udtalt (i en over fem timer lang podcast!), at hun ser det som et nøglepunkt at udvikle AI-assistenter, der kan skabe støtte uden at overskride de grænser, der bør gælde for ikke-menneskelige dialogpartnere.

Opgaven har et indbygget dilemma, fordi det er veldokumenteret, at menneskelige træk øger tilliden til AI-modeller og dermed også deres nytte i bl.a. psykiatri og demenspleje, men at selvsamme træk samtidig gør det svært ikke at danne relationer med dem.

Med alle de faldgruber – ikke mindst bedrag og manipulationsrisici – der følger med. Askell udtrykker sin ydmyghed overfor den svære opgave på meget lidt Silicon Valley-agtig vis når hun siger, at hun fremfor at ”over-performe” i jobbet snarere oplever, at hun er ”under-failing”.

Spring frem til 2 timer og 43 min. for interviewet med Amanda

Hvis vi derpå vender tilbage til Kyle Fish-ansættelsen, bør vi hilse det mere end velkomment, at Anthropic også adresserer de svære spørgsmål om bevidsthed. Om end jeg selv her og nu anser problemstillinger om menneske-AI-relationer, som væsentligt mere akutte.

Få kulturelle debatter kan være vigtigere end spørgsmålene om, hvad vi stiller op med den stigende grad af livagtighed, teknologien i vores hænder leveres med.

De vigtige spørgsmål lige nu

De følgende spørgsmål og indsigter finder jeg selv særligt vigtige, og jeg håber, at de med tiden vil blive genstand for offentlig samtale:

- Det er meget svært for mennesker at undgå at antropomorfisere – menneskeliggøre – teknologi, der deler træk med mennesker og dyr. Både sprog og udseende.

- Vi bestemmer ikke selv, hvad vi har empati med, og mange studier har vist, at vi har meget let ved at udvikle empati med robotter og chatbots.

- Den måde, sprogmodeller er udviklet på, kan ikke skabe bevidsthed som hos biologiske væsener. Det, der kommer ud af en sprogmodel, er beregninger, og selvom sprogsimuleringen er livagtig, kan den ikke siges at tænke i menneskelig forstand.

- Det, at vi har empati med AI-teknologi, og at AI-teknologi kan udvise empati med os og f.eks. genkende vores følelser, gør det til et nyttigt redskab i psykiatrien. Men vi må ikke forveksle det med, at der er følelser under ”kølerhjelmen”.

- Selvom en AI-model ikke kan føle smerte og glæde, kan det godt være en moralsk forkert handling at mishandle den. Hvad gør det ved menneskers moral at mishandle menneske- og dyrelignende teknologi?

- Hvordan griber vi det an, at det synes ufornuftigt at give menneskelignende teknologi krav på moralsk omsorg, mens det samtidig synes ufornuftigt at tillade fornedrende opførsel overfor menneske- og dyrelignende teknologi?

- Hvordan undgår vi, at teknologi, vi udvikler empati med, og som føles levende, misbruges til kommerciel og politisk manipulation, hvis vi ikke ønsker at forbyde den slags teknologi helt?

- Et produkt som AI-dating-chatbotten Replika, der har millioner af ”menneskekærester” er kommerciel og lever af menneskets psykologiske tilbøjelighed til at tro, at visse AI-modeller er levende. Er det moralsk i orden? Bør det være lovligt? (er det lovligt ifølge AI Act?)

Listen er langt fra udtømmende, men det er spørgsmål som disse, jeg håber vil blive anerkendt som væsentlige for os alle som betydende for, hvilken menneske-teknologi-relation, vi udvikler.

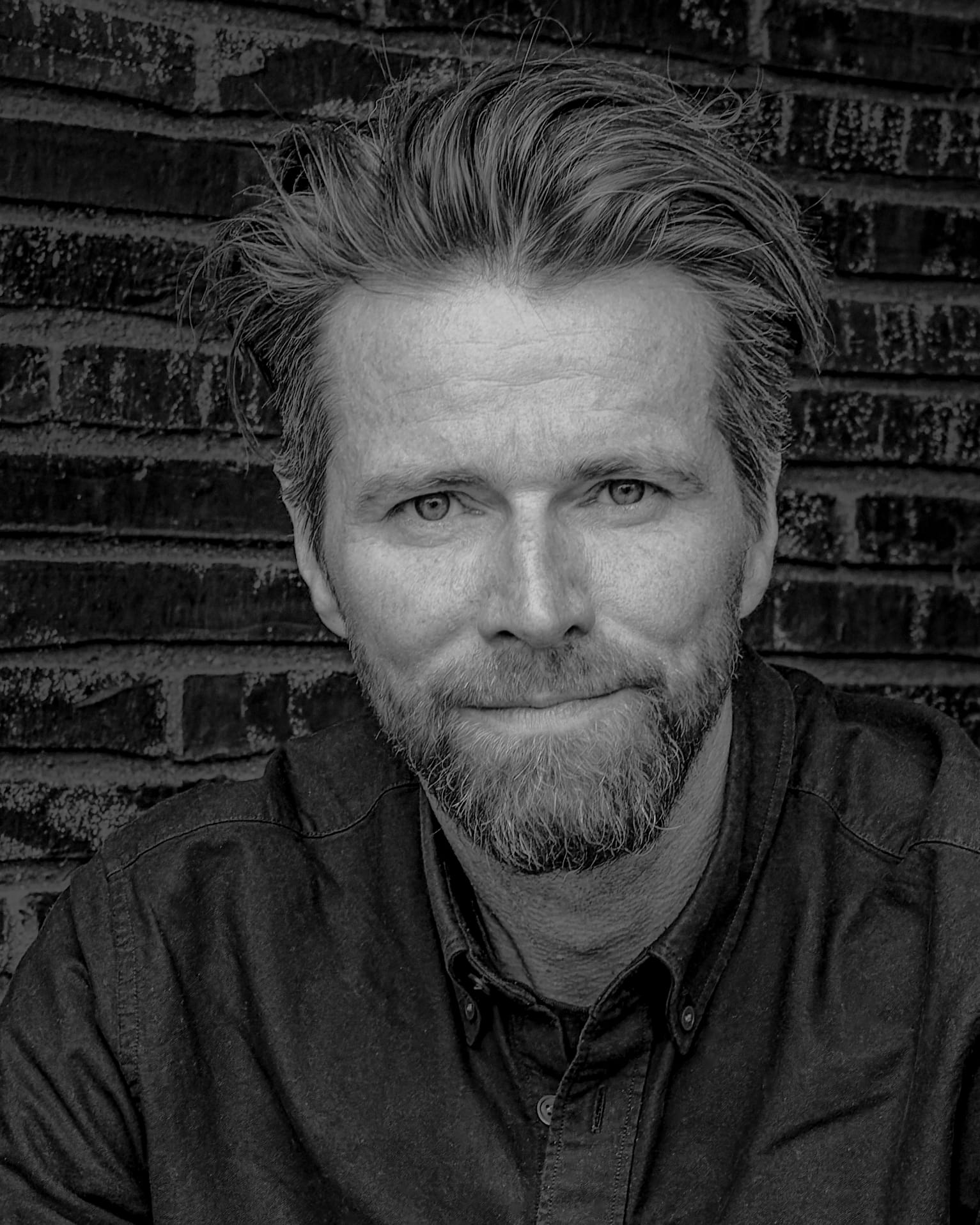

Om Thomas Telving

Thomas Telving er cand.mag. i filosofi og statskundskab og har siden starten af 00’erne arbejdet som bl.a. kommunikationschef, pressechef, politisk chef og konsulent. Han er i dag foredragsholder og konsulentmed speciale i kunstig intelligens, etik og filosofi. Han er forfatter til bogen "Killing Sophia - Consciousness, Empathy, and Reason in the Age of Intelligent Robots” fra 2022 samt mere end 50 artikler om etik og kunstig intelligens. I april 2024 udkom Thomas Telvings ungdomsfilosofibog “Kære Mille - Et brev om livet”.